Na Coluna Tecnologia que Humaniza, Guilherme Cintra aprofunda por que o debate sobre IA e relações humanas se torna decisivo neste momento

Na primeira coluna da série, descrevi o que chamo de Tecnologia que Humaniza e como esse conceito se cristalizou como um foco de atuação ao longo da minha trajetória.

Três elementos orientam esse tipo de tecnologia: têm como foco as relações humanas; partem de princípios científicos e pedagógicos do que funciona; se pautam por princípios éticos.

Mas mais do que só uma obsessão pessoal, acredito que agora, mais do que nunca, o tema importa para nossa sociedade.

Quase exatamente 3 anos atrás, em novembro de 2022, o ChatGPT foi lançado ao mundo nos pondo de frente com uma tecnologia que “se comunicava” de forma muito parecida à de um humano.

Nossa imaginação fluiu, em apenas 2 meses mais de 100 milhões de pessoas já haviam usado a ferramenta e começamos a entender como nossas vidas poderiam ser impactadas por aquela categoria de tecnologia.

Em educação, uma mistura de entusiasmo, preocupação e até mesmo medo era palpável.

Passados três anos, já é possível ter maior dimensão dos impactos da IA generativa em nossas vidas. E isso reforça uma série de aspectos que tornam o foco em tecnologias que humanizam, mais necessário.

Fricção cognitiva segue sendo fundamental. Só que é mais difícil promovê-la

Uma das grandes promessas da IA no contexto educacional é a capacidade de desenvolver tutores que conseguem, 24 horas por dia, responder qualquer questão daqueles que buscam conhecimento. Isso permitiria personalização de acordo com as necessidades individuais de cada aluno, responderia às formas como aprendem melhor seus interesses…

Essa promessa não é nova. O professor de psicologia de Harvard B.F. Skinner, um dos principais nomes do behavorismo, em 1953, ao visitar a escola de sua filha, ficou provocado a criar uma solução para um problema que enxergava. O que viu foram alunos fazendo exercícios, todos ao mesmo tempo. O professor passando pelas colunas de alunos dando feedbacks no ritmo que era capaz. Isso gerava ansiedade naqueles que demoravam mais e desengajava aqueles que terminavam mais rápido. Assim, foi impelido a desenvolver uma versão primitiva de um computador com ensino adaptativo: usando uma caixa, cartões de papel perfurado, alavancas e luzes, o aluno poderia fazer os exercícios e receber feedbacks automáticos.

Mas lógico, a tecnologia que temos hoje, com Inteligência Artificial Generativa que não somos nem capazes de compreender completamente com nossa limitada cognição humana, resolve essa questão muito melhor. Certo?

Bem, após quase 3 anos da IA generativa na mão de milhões de pessoas, não houve uma revolução educacional. Tecnologias para aprendizagem têm adotado modelos de IA para uma série de casos de uso importantes e com potencial. Não acredito que IA irá “resolver a educação”. Mas ela pode ajudar. Como?

Primeiro é importante lembrar de um princípio básico. Aprendemos com fricção cognitiva. Ou seja, nos esforçando. Chame de “esforço produtivo”, pense em Vigotsky e sua “zona proximal de desenvolvimento”… o conceito é bem estabelecido há décadas.

Aplicações gerais como ChatGPT, Claude ou Gemini nos dão soluções prontas. Sua função primordial não é ensinar. Suas versões “modo de estudo” ainda não fazem um trabalho suficientemente bom em limitar as interações que levam a fricção necessária à aprendizagem.

E mesmo soluções educacionais que construíram os chamados “guardrails”, ou seja, estratégias de design que limitam o tipo de resposta que o modelo dá e buscam métodos mais socráticos, induzindo o aluno ao raciocínio, seguem com o desafio usual de engajamento. A barreira dos 5% de alunos que têm interesse suficiente em estudar, o que chamamos de motivação intrínseca, não foi ainda resolvida por tecnologia em si.

Confesso que achei que dessa vez poderíamos avançar mais. Mas até aqui, ainda não. O desafio de engajamento segue e com isso a relevância das relações humanas para geração de motivação e diretrizes para uso adequado de tecnologias. E com isso, formação de educadores e monitoramento de indicadores de uso serão ainda parte fundamental das operações de instituições educacionais que incorporam tecnologia em suas práticas.

Isso tudo significa que, deveres de casa e avaliações precisarão ser modificados. Afinal, as experiências educacionais precisarão encontrar os novos espaços e momentos de fricção cognitiva viáveis em um mundo onde precisamos assumir que os alunos usarão ferramentas de IA generativa.

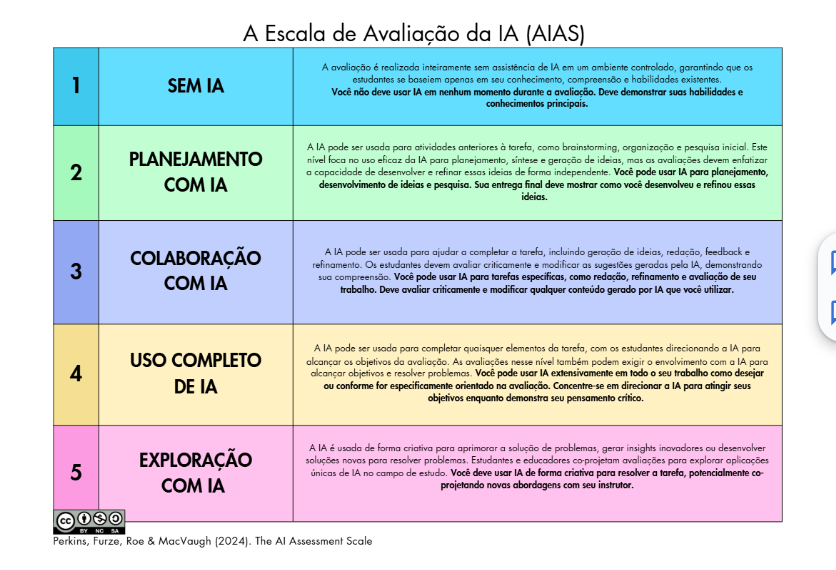

Um exemplo de guia para pensar nessa integração é a Escala de Avaliação da IA:

Como os autores da escala afirmam, trata-se de uma forma de refletir sobre cada uma das atividades que são planejadas por educadores em uma instituição educacional. Dependendo dos objetivos pedagógicos você pode querer que o aluno não use qualquer IA. Até ser parte do processo de reflexão e, portanto, obrigatório, o uso de IA.

Para cada um dos casos, o foco da fricção cognitiva está em uma parte diferente do processo que leva ao resultado final. Afinal, é o design dessa experiência de aprendizagem, reconhecendo que a IA existe no mundo, que está disponível para os alunos e, portanto, precisa ser considerada, que levará à internalização do conhecimento.

Distinguir fato de opinião é ainda mais fundamental. E mais complexo

Tanto educadores como alunos precisam ser formados para compreenderem que uma resposta rápida não é, necessariamente, uma boa resposta. E nem uma resposta eloquente.

O uso do termo “ferramentas” aqui, que eu mesmo tenho feito, tem sido, inclusive, considerado por muitos como inadequado. Modelos de IA generativa carregam em si visões de mundo particulares. Algo que não é diferente dos algoritmos de busca tradicionais. Porém, se já era difícil distinguir quais eram os “links azuis” nos quais podíamos confiar, aqui a realidade está ainda mais opaca. A maior parte dos usuários não busca fontes, lê a resposta e segue como se o que está escrito em tela viesse de um oráculo. Até porque esses modelos são excelentes em dar respostas que soam convincentes e reforçam os próprios vieses de quem as utiliza.

Pensar nesses algoritmos como “ferramentas” nos dá um senso de controle sobre uma tecnologia que está mais para uma complexa infraestrutura cultural. E nosso uso tem que ser feito de acordo com toda essa complexidade que carrega.

O peso da educação midiática é cada vez mais relevante. Entender como as mídias funcionam, quem as produz e os interesses por trás. E entender que as tecnologias que estão presentes em nossas vidas são feitas por gente.

Um exemplo prático que pode ser aplicado em sala é o framework criado por Mike Caulfield, pesquisador da Universidade de Washington. SIFT, a sigla em inglês para Pare (Stop), Investigue (Investigate), Encontre (Find) e Rastreie (Track). Ao encontrar uma informação, devemos ensinar alunos e professores a parar, investigar as fontes, encontrar outras para saber se não é uma fonte única e rastrear a fonte original.

Isso nos permite sair de um mundo onde terceirizamos a verdade para tecnologias e trazemos de volta as relações humanas que existem na construção e uso destas nos apropriando e usando de fato ferramentas em vez de sermos usados como ferramentas.

E as relações?

Até aqui falamos apenas de aspectos cognitivos. Mas se as relações humanas estão e devem permanecer no centro, temos ainda que olhar para essa dimensão.

A diretora de educação do Clayton Christensen Institute, Julia Freeland Fisher vem fazendo um importante trabalho de pesquisa nos impactos da IA em nossas relações. Esse instituto foi fundado pelo acadêmico e consultor homônimo que cunhou o termo “inovação disruptiva”.

Eu não gosto do uso do termo disrupção em educação. Mas não pelo que ele é. É por seu mau uso. O termo original, refere-se a tecnologias que nascem com qualidade mais baixa que as que poderiam substituir, mas em regiões ou mercados com baixo acesso. Ao ser a única opção disponível para esse público, podem se desenvolver até se tornarem boas o suficiente para tomar espaço da tecnologia incumbente.

Exemplo clássico são os celulares na África Subsaariana. Com pouquíssimas pessoas com acesso a linhas telefônicas, os celulares, que precisam de menor infraestrutura, serviam às populações rurais e de baixa renda. Ao longo do tempo, tornaram-se a principal forma de comunicação, saltando etapas de infraestrutura e criando um novo ecossistema de soluções digitais a exemplo do M-Pesa, meio de pagamentos queniano mesmo sem um sistema bancário que atenda a boa parte da população.

E o que isso tem a ver com nosso tópico?

Até pouco tempo atrás, quando falava da minha preocupação com Companheiros de IA, as pessoas me olhavam meio torto. Como se eu estivesse vendo filmes de ficção científica em excesso.

Relatório de abril de 2025 da Common Sense Media, referência em mapeamento de riscos de uso de tecnologia por crianças e adolescentes mostra como, ao menos nos EUA, mais de 70% dos adolescentes já usaram essas ferramentas com mais de 20% afirmando confiar muito nessas ferramentas.

Enquanto boa parte portanto usa companheiros apenas como uma ferramenta que é “legal” mas não interessante suficiente para efetivamente substituir relações humanas, há uma minoria, potencialmente sem acesso a relações saudáveis com outras pessoas, que passará a ter em chatbots seus verdadeiros companheiros. Esse mercado é grande o bastante para as ferramentas eventualmente poderem se tornar boas o suficiente para disruptarem relações de pessoas que já têm redes de amigos bem estabelecidas.

Pensando de maneira mais pragmática, é por meio de nossas relações que conseguimos também nos posicionar profissionalmente, evoluir na carreira. Principalmente pelas relações que se configuram como “laços fracos”. No trabalho do pesquisador Mark Granovetter, ele define esse tipo de vínculo como aquelas conexões mais distantes ou esporádicas como ex-colegas ou contatos ocasionais. Diferentemente dos “laços fortes” com amigos ou familiares que fornecem apoio emocional ou confiança para projetos de longo prazo, os “laços fracos” nos permitem acesso a novas ideias e empregos que estão, usualmente, fora dos nossos círculos habituais.

Ao termos “ferramentas” que nos dão soluções mais mastigadas e diretas para problemas complexos, corremos o risco de substituir aquela ligação para algum desses “laços fracos” para uma troca com um chatbot. E isso nos priva de relações importantes.

Ou seja, tanto laços fortes como laços fracos podem ser ameaçados se não pensamos intencionalmente em seu valor e nos relacionamos de acordo. Não é à toa que a Common Sense, organização referência no mapeamento de riscos de tecnologias para jovens tem como parte de seus critérios de avaliação de soluções que utilizam IA, o suporte a conexões humanas.

Em resumo, há formas positivas de usar IA na educação. Entretanto, essas formas demandam intencionalidade tanto nos elementos cognitivos como nos relacionais. Precisamos de uma visão crítica. Isso não é novidade. Usar tecnologia sempre demandou visão crítica. A grande diferença é que agora, as ferramentas com as quais interagimos são mais convincentes, parecem mais com humanos e são mais atraentes do que nunca. Bem…como alguns dizem, talvez não sejam nem ferramentas.

Guilherme Cintra é Diretor de Inovação e Tecnologia da Fundação Lemann. Economista formado pela PUC-RJ, iniciou sua trajetória na educação aos 18 anos como professor de matemática para jovens de comunidades próximas à universidade. Atuou em fundos de investimento e tornou-se sócio do Gera, focado em educação. No Grupo Eleva, foi diretor de unidade escolar, liderou uma rede de escolas e cofundou o Pátio, área de novos negócios (hoje Grupo Salta). Trabalhou na Secretaria Municipal de Educação do Rio de Janeiro como Coordenador de Inovação e Tecnologia, onde criou os Ginásios Experimentais Tecnológicos, a Olimpíada Carioca de Matemática e sistemas de gestão escolar. Atualmente, dedica-se a escalar qualidade educacional por meio da tecnologia em estados e municípios do país.